Im Rahmen einer kleinen Studie haben wir uns angesehen, was drei aktuelle Werkzeuge zur automatischen Qualitätsbewertung deutschsprachiger Webtexte (YoastSEO, wortliga.de, rechtschreibpruefung24.de) leisten. Dabei ging es zum einen darum, die Kategorien zu erkennen, nach denen die Tools die Qualität eines Textes bewerten, aber auch zu hinterfragen, inwieweit die automatischen Bewertungen den Urteilen von Menschen entsprechen. Hierfür wurden die Ratings für drei Textpaare verglichen: (1) einen als gut und einen als schlecht bewerteten Schüleraufsatz; (2) einen prämierten Blogbeitrag und einen Blogbeitrag mit deutlichen Mängeln; (3) zwei Texte von AutorInnen des deutschen Literaturkanons (Kafka und Jelinek).

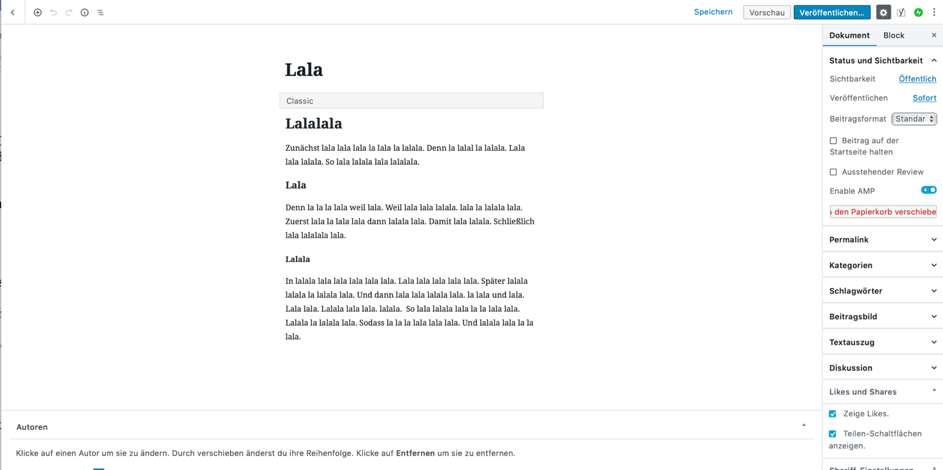

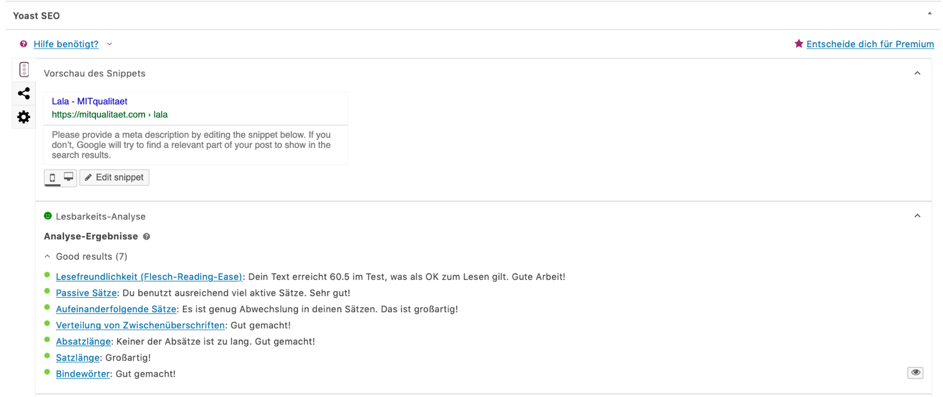

Gerade der Vergleich von Schülertexten war im Hinblick auf die Validität der Textbewertung aufschlussreich, wurden sie vorher doch bereits von Menschen beurteilt. Selbst ein Schüleraufsatz mit offensichtlichen Mängeln erhielt noch erstaunlich viele positive Bewertungen von den automatisierten Werkzeugen (Yoast SEO: „Du benutzt ausreichend viel aktive Sätze. Sehr gut!“; „Aufeinanderfolgende Sätze: Es ist genug Abwechslung in deinen Sätzen. Das ist großartig!“).

Neben Kriterien wie dem Lesbarkeitsindex, der Satzlänge oder der Verwendung von Passivkonstruktionen bewerten die Tools teilweise auch Wort- und Satzlänge, das Layout betreffende Aspekte (z.B. Zwischenüberschriften oder die Absatzlänge), aber auch die Vermeidung bestimmter grammatischer Phänomene (wortliga.de: „Vermeide Passiv-Sätze“; „Vermeide Zeitform Perfekt“). Orthographische Fehler korrigiert nur rechtschreibpruefung24.de.

Vor allem fällt auf, was die Tools nicht leisten. Die „Überlistung“ der Werkzeuge ist, wie auch Dominik Horn in seinem Beitrag gezeigt hat, dementsprechend simpel: ein selbstkonstruierter sinnfreier und inkohärenter Text wird beispielweise von Yoast SEO und wortliga.de positiv bewertet und mit Aussagen wie „Super! Keiner Deiner Sätze ist zu lang“ oder „Es ist genug Abwechslung in deinen Sätzen. Das ist großartig“ (Yoast SEO) geschmückt. Hier werden die Grenzen der technischen Hilfsmittel schnell deutlich.

Gerade die von den Schreibratgebern immer wieder betonte Einbindung von multimodalen Elementen, wie Bildern oder Videos, wird von den Tools erst gar nicht erkannt. Komplexe, aber entscheidende Qualitätsaspekte, wie die Kohärenz eines Textes, werden von den getesteten Werkzeugen ebenso wenig berücksichtigt. Entscheidend ist, dass nicht alleine die Lesbarkeit eines Textes zu dessen Optimierung führt. Für digitale Kommunikation sind auch noch Kategorien, wie Vernetzung/Verlinkung oder Interaktion entscheidend (siehe dazu den Blogbeitrag zu den neuen Kategorien, der bald folgt) – nach diesen Qualitätsdimensionen sucht man ebenfalls vergeblich. Die Kategorien, nach denen die Tools Webtexte bewerten, orientieren sich weitestgehend an Kriterien für Offline-Texte. Alleine die Wahl sogenannter Keywords für die Suchmaschinenoptimierung bezieht sich auf Webtexte. Dabei geht es darum, eine größere Reichweite zu erzielen und über Google und Bing mehr UserInnen auf die Homepage zu führen. Bei der Premiumversion von Yoast SEO ist es etwa möglich, mehrere „related Keywords“ anzugeben. Das Tool zeigt dann an, ob das Keyword häufig genug, aber nicht zu häufig verwendet wird und prüft auch, ob Synonyme im Text verwendet werden.

Die Twitter-Userin Savannah Lauren bringt es unfreiwillig auf den Punkt, wenn sie über Yoast SEO schreibt: „i love that really good feeling you get when the yoast app says your seo is good with its green light”. Genau hierhin scheint die Attraktivität derartiger Tools zu liegen: dem Autor/der Autorin wird mit den grünen Ampeln ein gutes Gefühl beim Schreiben von Texten gegeben. Über die Qualität des Textes sagt das aber wenig bis gar nichts aus.

Dies ist der dritte Blogpost zu unseren Projektergebnissen. Weitere Beiträge folgen. Unsere vollständigen Ergebnisse publizieren wir 2020 im Sonderheft Deutsche Sprache (2/2020 Open Access). Über die Veröffentlichung informieren wir auf unserem Blog. Teil 1 und 2 der Projektergebnisse sind bereits online, weitere folgen.